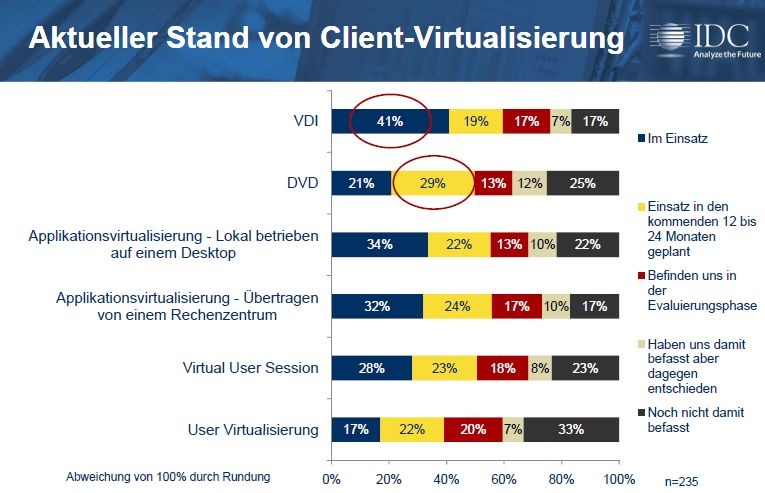

Eine Microsoft-Analyse – allerdings noch mit Werten der alten Lizenzbedingungen – hat die Total Cost of Ownership normaler PCs und virtualisierter Desktops verglichen. Dabei waren letztere sogar um elf Prozent teurer. Eine Studie von Gartner sieht für die virtualisierten Arbeitsplätze einen Kostenvorteil von gerade einmal zwei Prozent. Wie die aktuelle IDC-Umfrage zeigt, geht es den Anwendern aber in erster Linie gar nicht um Kosteneinsparungen – und wenn, dann eher beim Betrieb als bei Lizenzen und Geräten.

Das liegt auch daran, dass der Anstoß für ein Projekt zur Client-Virtualisierung meist von Systemadministratoren oder den Verantwortlichen für IT-Sicherheit ausgeht. Den ebenfalls sehr aktiven Rechenzentrumsverantwortlichen darf dagegen ein hohes Eigeninteresse unterstellt werden: Ziehen sie das Projekt an Land, können sie davon ausgehen, dass ihr Budget und ihre Aufgaben erheblich wachsen.

„Jede Form der Virtualisierung frisst erhebliche Mengen an Speicherplatz“ sagt Alexander Wallner, Area Vice President Deutschland bei NetApp (Bild. NetApp).

Gerd Wörn, Head of Competence Center Desktop Services bei T-Systems, hat bereits einige Erfahrungen mit Virtualisierungsprojekten bei Kunden. Er hat bei der Vorstellung der IDC-Studie in München auf zahlreiche weitere Schwierigkeiten hingewiesen und die Ergebnisse der Studien von Microsoft und Gartner zu den Kosten bestätigt: „Eine VDI ist heute sogar leicht teurer als ein gemanagter Desktop. Das liegt daran, dass besonders in Deutschland die Firmen beim Managed Desktop gute Arbeit geleistet und die Angebote weitegehend optimiert haben. Kommt eine VDI dazu, entstehen erst einmal Mehrkosten, da zusätzliche Technologie beschafft und verwaltet werden muss.“

Hohe Anforderungen an die Speicherinfrastruktur

Alexander Wallner, Deutschland-Chef von NetApp, bestätigt diese Einschätzung. Seiner Erfahrung nach entfällt heute bereits rund ein Drittel der Ausgaben für Rechenzentren auf Storage. VDI-Projekte stellten per se ebenfalls hohe Storageanforderungen. Allerdings ließen sich diese durch den geschickten Eisnatz von Technologie reduzieren. „Die virtuellen Maschinen sind fast zu 100 Prozent identisch, da bietet sich Deduplizierung geradezu an. Dadurch ist eine Reduzierung der benötigten Kapazität zwischen 50 und 90 Prozent möglich.“

Ein weiteres – aber lösbares – Problem sieht Wallner in den Anforderungen, die auf die Speicherinfrastruktur dadurch zukommen, dass die Clients sich unter Umständen nahezu gleichzeitig viele Daten holen müssen. Er spricht in diesem Zusammenhang vom „Bootstorm“ – wenn morgens vor Arbeitsbeginn innerhalb einer Viertelstunde hunderte von virtualisierten Desktops bereitgestellt werden müssen. Abfangen ließe sich der durch den ausbalancierten Einsatz von SSDs im Rechenzentrum. Rein plattenbasierende Strukturen seien damit dagegen oft überfordert.

Wörns Fazit lautet dennoch: „Client-Virtualisierung kann Kosten senken – aber in der Regel erst, wenn über die Hälfte der Desktops virtualisiert wird.“ Soweit sind aber die meisten Firmen noch nicht. Sie probieren aufgrund der Vielfalt der verfügbaren Technologien und deren unübersichtlichen Vor- und Nachteilen noch aus, was für sie am besten passt.

„Eine eigentlich so einfache Anwendung wie ein Media Player ist immer noch ein Feind der Virtualisierung“, so Wörn. Außerdem funktionierten etwa beim Applikations-Streaming oft so etablierte Funktionen wie Copy-and-Paste zwischen den einzelnen Anwendungen nicht zuverlässig. Und beim Einsatz von Thin Clients oder sogar Zero Clients verliere man – trotz gegenteiliger Behauptungen der Anbieter – immer noch an Komfort, so Wörn. Das heiße jedoch nicht, dass er keinen Platz für diese Angebote sieht. „Ich glaube aber nicht, dass sich wegen der Vielfalt der Anforderungen alle Ziele mit einer Technologie erreichen lassen.“

Ein Beispiel aus der Praxis

Volker Kunert, Projektverantwortlicher beim Bankhaus Metzler wird in nächster Zeit rund 700 Arbeitsplätze virtualisieren. Das ist keine Bauchentscheidung, sondern gründlich vorbereitet und geprüft: Seit 2008 beschäftigt sich das Unternehmen mit dem Thema. Anlass dafür war die Unzufriedenheit mit dem Ist-Zustand: Updates und Upgrades stören den Arbeitsablauf, lokale Userprofile verursachen erheblichen Administrationsaufwand, die Möglichkeit, Daten lokal abzulegen, ist aus Sicherheitsgründen nicht mehr zeitgemäß und die dynamische Zusammensetzung von Teams bringt viele Veränderungen mit sich, die einen hohen Aufwand verursachen. Außerdem pflegt das Unternehmen rund 150 Notarbeitsplätze – die zwar nie benötigt werden, aber ständig aktuell gehalten werden müssen, um im Fall der Fälle sofort einsatzbereit zu sein.

Die ausgiebigen Versuche führten zunächst dazu, dass man die Backend-Infrastruktur auf- beziehungsweise umrüstete. Beispielsweise wurden Ergänzungen bei der Storage-Landschaft notwendig. Aber auch Abläufe müssen neu durchdacht werden: Hat ein Client aufgrund einer Fehlkonfiguration ein Problem, ist das überschaubar, haben alle eines, ist das eine Katastrophe. „Eine durchdachte Qualitätssicherung ist daher unbedingt notwendig“, sagt Kunert. Außerdem berichtet er, dass sein Unternehmen sich viel Gedanken über das Softwaremanagement, die Standardisierung sowie das Profilmanagement und die Definition von Richtlinien gemacht habe – Aspekte, ohne die es seiner Ansicht nach nicht geht.

Unterm Strich würde Kunert das Projekt wieder angehen. Das würde seiner Ansicht nach heute auch schneller gehen, seien doch die Werkzeuge und die Virtualisierungssoftware deutlich ausgereifter, als noch vor zwei Jahren. Allerdings seien weiterhin einige Baustellen offen: Manche Anwendungen sträubten sich immer noch gegen Virtualisierung und die erforderliche Einbindung mobiler Geräte stecke trotz der bereits vorhandenen Angebote noch in den Kinderschuhen. Firmen, die sich mit dem Gedanken an Client-Virtualisierung beschäftigen, empfiehlt Kunert die Vielschichtigkeit nicht zu unterschätzen und das Projekt keinesfalls unter Zeitdruck anzugehen.

Neueste Kommentare

Noch keine Kommentare zu Client-Virtualisierung: Bringen neue Ansätze den Durchbruch?

Kommentar hinzufügenVielen Dank für Ihren Kommentar.

Ihr Kommentar wurde gespeichert und wartet auf Moderation.